随着 高性能计算 (HPC) 工作负载的不断增加,人工智能数据中心正在部署液冷解决方案,以改善热管理。最常见的方案之一是冷板液冷,它利用液体的高导热特性来散热单个处理器芯片。

对于致力于利用 人工智能 (AI) 并保持竞争优势的企业而言,空气辅助液体冷却技术具有战略优势。结合高效的房间冷却和直接液体冷却方法,可以帮助企业降低能源成本、提升性能并满足 AI 数据中心的需求。

数据中心液冷概述

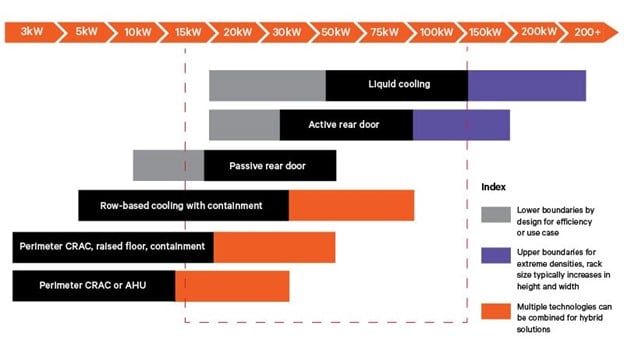

人工智能、机器学习 (ML) 和数据分析等高性能计算 (HPC) 服务的广泛应用,导致芯片、服务器和机架密度及功耗快速上升。随着机架密度上升至 20 千瓦 (kW) 并迅速逼近 50 kW,HPC 基础设施的发热量正在将传统房间冷却方法的性能推向极限。此外,全球数据中心和其他企业面临着越来越大的持续 降低功耗的 压力。为了满足这些需求,数据中心运营商正在研究其液冷方案( 见图 1)。

液冷利用水或其他介电流体更高的导热性能,高效地散发服务器组件的热量。对于高性能计算 (HPC) 基础设施而言,该解决方案比单纯使用风冷的效率高出 3,000 倍 ,而高性能计算 (HPC) 基础设施的发热量远超传统方法。液冷涵盖了人工智能数据中心的各种热量管理技术。

HPC 冷却选项

数据中心运营商目前采用三种液冷方案:建设完全采用液冷的数据中心、改造风冷设施以支持未来的液冷机架,以及将液冷集成到现有的风冷设施中。大多数运营商可能会选择后一种方法来提高容量、满足当前业务需求并快速获得投资回报。高性能计算 (HPC) 基础设施的液冷选项包括 后门热交换器 (RDHx)、冷板液冷和浸没式液冷。

了解详情

数据中心的液冷选项

随着处理密集型计算应用的增长,数据中心运营商正在评估液冷技术以提高能源效率。

了解冷板液冷

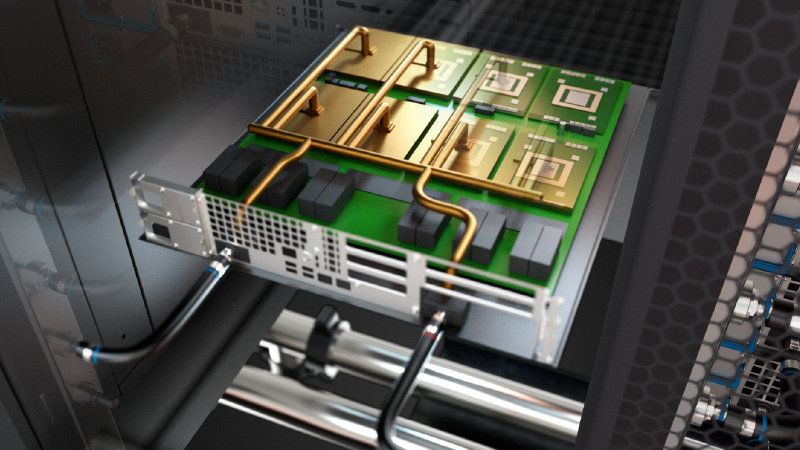

冷板液冷是一种先进的热管理技术,主要用于使用 高性能计算 (HPC) 硬件 的数据中心,以实现高效散热。 该方法通过冷板将安全的介电液体冷却剂直接循环到计算机芯片表面,从而高效吸收和散热 (见图 2)。无论负载和外部气候如何,这都能使处理器的温度保持在最佳水平。

冷板液冷可提高能源效率,最大限度地降低过热风险,并提升整体系统性能。 高性能计算 (HPC) 数据中心 运营商认为这种方法是一种高效的数据中心冷却方法,因为它直接作用于处理器和其他硬件的发热组件。 随着数据中心不断发展以应对日益增长的计算需求并追求更高的密度和效率,这项技术尤为重要。

冷板液冷系统的基本组件

冷板液冷技术可直接从芯片散热,使数据中心能够支持更高的机架密度,同时最大限度地提高能源效率。该液冷解决方案包含多个可无缝协作的组件。冷板液冷的组件包括:

- 冷却液由专门为冷板液冷设计的介电化合物或流体组成

- 移动液体的管子(或循环器)

- 液体可以通过的板

- 将热量从热源传导至板的热界面材料

冷板液冷如何工作?

冷板液冷通过单相或两相过程散热。这些方法提高了人工智能数据中心冷却系统的效率。

单相冷板液冷

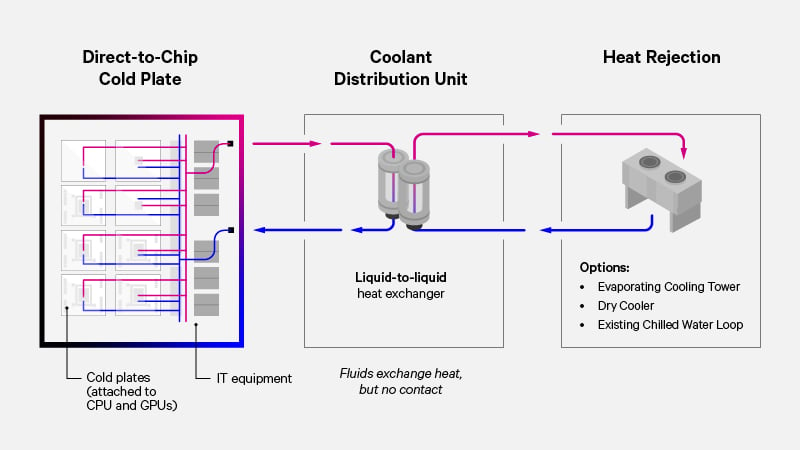

单相冷板液冷技术使用冷板来传导 CPU 和 GPU 等服务器组件的热量。冷却液吸收热量并流经冷却液 分配单元 (CDU),然后由热交换器将其转移到另一种介质中,排放到室外(参见 图 3)。非导电冷却液可降低电气风险,增强系统安全性和可靠性。

流体的选择 取决于流体的热捕获性能和粘度。水具有最高的热捕获能力,但通常会与乙二醇混合,这会降低热捕获能力,但会增加粘度以提高泵送效率。这些系统也可以使用介电流体来减轻泄漏造成的损害;然而,介电流体的热传输能力低于水/乙二醇混合物。

两相冷板液冷

采用双相冷板时,低压介电液体会流入蒸发器,服务器组件产生的热量会使液体沸腾。产生的蒸汽将热量从蒸发器带走,并将其传输到机架外部,从而实现有效的散热。

冷板液冷的优势

计算冷板液冷带来的效率,该技术因其为行业提供的持续学习和创新而获得发展动力:

提高可靠性和性能:冷板液冷和其他液冷解决方案最大限度地降低了过热的风险,并保持了均匀、较低的工作温度,这对于维持 HPC 硬件 的可靠性和寿命以及避免性能下降至关重要。

更好的系统设计和部署考虑:冷板液冷可以无缝集成到现有的服务器设计中,最大限度地减少对操作的干扰并简化部署过程。

随时可用的可扩展性:液冷技术允许在更小的物理空间内容纳更多处理器,无需扩容或新建。通过提供更有效的热管理,冷板液冷技术可实现按需扩展,从而更轻松地扩展业务,而不会影响性能和运行服务。

降低总拥有成本 (TCO): 美国采暖、制冷与空调工程师学会 (ASHRAE) 在其 报告中发现,与纯风冷系统相比,同时采用风冷和液冷的数据中心可以降低 TCO。TCO 的降低得益于更高的密度、自然冷却利用率以及每瓦性能的提升。

阅读有关 HPC 冷却的电子书

DCD冷却转变

据 Datacenter Dynamics 报告,冷却系统占数据中心总能源费用的 40%。因此,找到最佳解决方案的重要性不容低估。

数据中心液冷部署的准备

由于企业拥有不同的计算需求,因此不存在通用的AI冷却解决方案。为了满足其独特的需求,现代数据中心(包括专注于人工智能的数据中心)可以通过执行以下步骤开始部署冷板液冷或其他HPC冷却方法:

确定冷却要求:IT 和设施团队必须决定如何为新的 AI 或高性能计算工作负载分配资源,以满足未来一到两年的当前和未来需求,无论是一次转换几个机架还是专用整个房间。

测量热足迹:冷却团队需要识别 AI 配置、评估非标准要求并评估当前气流,同时解决新热负荷和冷却极限之间的差距。

评估流速:团队可能会选择根据 IT 设备的生命周期升级冷却解决方案,特别是如果即将到来的硬件更新需要为下一代芯片提供额外的容量。

探索数据中心冷板液冷部署解决方案

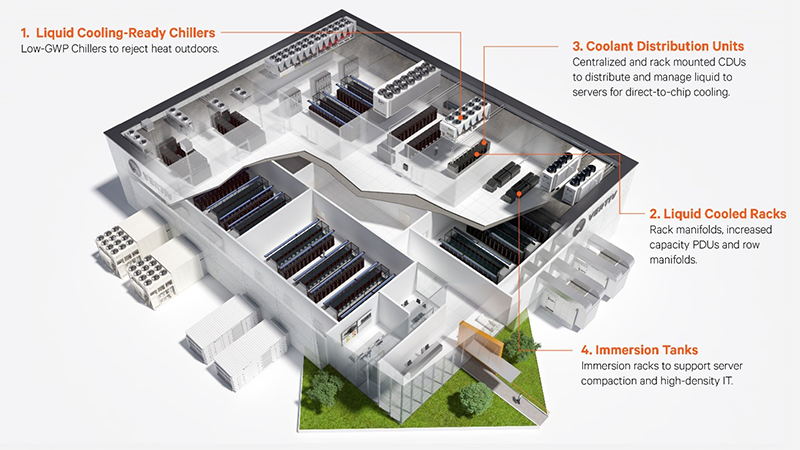

IT 和设施团队可以在安装专用基础设施后开始部署冷板液冷或其他数据中心液冷解决方案,该基础设施可创建流体冷却回路,实现设施和二次回路之间的热传递,并使用除设施水之外的流体进行冷却(见图 4)。

液对液CDU

冷却液分配单元 (CDU) 为冷板液冷、 后门热交换器和浸没式液冷系统提供受控、无污染的冷却液。 拥有冷冻水接入的团队可以使用液对液 CDU 为 液体冷却的 IT 设备提供单独的冷却回路,使其与设施的主冷冻水系统隔离。选择此解决方案允许他们选择机架的流体和流速,例如处理过的水或水-乙二醇混合物。

与通常在非高峰时段和淡季关闭的 传统舒适性制冷系统 不同,冷冻水系统必须持续运行才能成功部署。在使用现有冷冻水系统时,通过过滤方案优先考虑水质也至关重要。此外,液对液冷冻水分配单元 (CDU) 需要安装管道和泵来连接设施水源,这可能会影响部署时间。

液-气CDU

液-气冷却液分配单元 (CDU) 为机架提供独立的二次流体回路,即使没有冷冻水也能有效散热。加热后的流体返回 CDU,并流经热交换器 (HX) 盘管。风扇将空气吹过这些盘管,从而将数据中心的热量散发出去。然后,现有的风冷基础设施会捕获这些热量并将其排放到室外,从而使数据中心能够继续使用传统的机房冷却方法,并采用冷板液冷的方式。

液-气冷却液分配单元 (CDU) 可以利用现有的房间制冷单元进行散热,从而加快液冷的部署。与液-液冷排单元 (CDU) 相比,该方案只需对水管与建筑系统进行少量改造,占用空间更小,安装和初始成本也更低。然而,液-空气冷却液分配单元 (CDU) 的冷却能力有限,这对于人工智能数据中心来说是一个重要的考虑因素。

液-冷媒CDU

液-冷媒冷却液分配单元 (CDU) 将液体直接输送至芯片,并利用基于制冷剂的冷凝器进行直接膨胀 (DX) 散热。这种方法可以最大限度地利用现有的 DX 基础设施,同时在需要时增强液体冷却能力。它使数据中心能够快速部署 HPC 冷却系统,而无需现场配备冷冻水,从而实现模块化设置,而无需彻底改造现有的冷却基础设施。

采用泵送制冷剂节能 (PRE) 散热技术的液—冷媒冷却液分配单元 (CDU) 可根据环境温度提供 冷却,从而降低能耗。内部组件冷却二次流体网络,从而将高密度冷却直接输送至服务器冷板。

后门热交换器(RDHX)

数据中心可以实施 RDHX,作为迈向 高密度 冷却的第一步。如果尺寸合适,RDHx 可以与现有的风冷系统配合使用,而无需对空白区域进行重大的结构改造。它们还可以消除对遏制策略的需求(参见 图 5)。无源装置适用于 5 至 25 kW 的负载,而 有源 RDHX的额定功率高达 50 kW,在某些情况下经测试可达 70 kW 以上。

成功实现冷板液冷集成的考虑因素

实施冷板液冷技术需要仔细评估可能影响其集成的各种挑战。关键考虑因素包括与现有基础设施的兼容性、有效的流体管理以及解决设备容量限制,以确保成功部署。

流体分布

设计安全高效的流体分配系统,将泄漏风险降至最低,并进行主动泄漏检测,对于成功部署至关重要。IT 和设施团队应验证化学成分、系统温度、压力和配件,以防止泄漏或故障。使用快速断开配件和截止阀可提高可维护性,方便配件断开,并实现快速泄漏干预。此外,关键基础设施组件(尤其是冷排水单元 (CDU) 的设计)至关重要。这些技术可以精确控制流体体积和压力,从而减轻任何泄漏的影响。

泄漏检测和干预

全面的 泄漏检测系统 可及时发出潜在问题警报,从而提高液冷装置的安全性和可靠性,有助于减少停机时间并防止设备损坏。间接检测方法监测压力和流量的变化,而直接检测方法则使用传感器或电缆来精确定位泄漏。正确设置这些系统至关重要;减少误报可以保持运营效率,同时仍能检测到需要紧急关注的实际泄漏。

与基础设施合作伙伴密切合作对于定制特定应用的系统非常重要,最大限度地提高手动和自动干预策略的有效性,以保护超过 30 kW 的高密度配置。

流体管理

流体管理涉及定制服务,以满足液冷系统的冷却剂需求。这些服务包括污染物清除、空气净化、冷却剂取样、质量检测、调整以及环保处置。通过与顶级冷却剂供应商合作,Vertiv 的流体管理服务可确保 Vertiv 液冷系统的最佳性能和可靠性。

阅读更多:

如何在现有数据中心实施液冷

随着人工智能 (AI) 和机器学习 (ML) 模型需求的激增,您可能会不断改进冷却策略并探索新的方案。本技术指南介绍了针对 1MW IT 负载采用液体冷却的实用策略,可帮助您制定液冷的路线图。

选择你的高密度之路

冷板液冷技术正在通过解决与高性能计算 (HPC) 工作负载(例如人工智能、机器学习和大数据分析)相关的高热负荷来改变数据中心。随着对处理能力的需求不断增长,更高效的冷却解决方案对于保持最佳性能至关重要。

自信地迈向高密度计算的下一步。无论您从哪里开始,无论您的目标是什么,Vertiv 都能定制解决方案,提升您数据中心的冷却能力。