支持千兆瓦级人工智能需要什么?Vertiv 和 NVIDIA 提供了以 GB300 NVL72 为核心的蓝图。

实现人工智能的愿景,取决于包括代理人工智能在内的大型语言模型的持续创新,以及 GPU 设计的进步。但这也需要人工智能模型、IT 硬件以及从电力和冷却角度支持它的基础设施之间更加紧密的协调。

Vertiv 数据中心细分战略与部署副总裁Martin Olsen专注于人工智能 (AI) 相关的 IT 和 OT 之间的接触点,并与 NVIDIA 等关键合作伙伴密切合作。Martin 最近讨论了 Vertiv 与人工智能领导者 NVIDIA 在多个领域的持续合作,包括最近发布的 GB300 NVL72 参考设计,该设计旨在实现千兆瓦级人工智能部署。该解决方案支持高达 142 kW 的机架密度,同时利用 NVIDIA Omniverse 进行 AI 驱动的模拟。

您如何描述 Vertiv 与 NVIDIA 的合作,尤其是在 AI 基础设施开发的背景下?

Martin Olsen (MO): 我们与 NVIDIA 的合作至关重要,而不仅仅是战略性的。它使我们能够领先一个 GPU 平台,并让我们能够洞察未来两到三代计算技术的发展。这种前瞻性的规划使我们的基础设施解决方案能够为未来的计算部署做好准备。我们是 NVIDIA 生态系统中的关键参与者,涵盖电源、散热、热控制和 AI 优化等关键支柱。通过整合我们的专业知识,我们使 NVIDIA 能够更快、更大规模地交付其 DGX 平台(包括 GB300 NVL72),在满足客户期望的同时,也为未来的需求做好了规划。

是什么让 Vertiv 成为 NVIDIA 在此次合作中的宝贵合作伙伴?

MO: NVIDIA 重视我们长期以来的信誉以及为全球主要客户提供服务的经验,这让我们与合作伙伴建立了信任。我们提供业界最全面的电源和散热产品组合,通过最大限度地减少基础设施接口,从而降低 NVIDIA 的复杂性。我们在工程、研发方面的巨额投资推动了创新,解决了复杂的数据中心挑战。这种端到端的能力,加上我们在电源、散热和控制方面的创新方法,创造了一种共生关系,增强了 NVIDIA 部署 GB300 NVL72 等先进 AI 系统的能力。

领先一步的GPU平台: 正如Martin Olsen所说,保持领先意味着要放眼当前计算时代之外。能够提前洞察下一代平台的数据中心领导者,能够更好地设计出为未来做好准备的基础设施。

为什么参考设计对于您与 NVIDIA 的合作如此重要?它们如何使客户受益?

MO: 参考设计是我们与 NVIDIA 合作的基石,是部署 GB300 NVL72 等加速计算的黄金标准。它们提供了完整的基础设施规格、物料清单和性能要求,以支持 NVIDIA 的 DGX 平台和 SuperPOD 集群。这些设计兼顾速度、规模、能效和可维护性。它们并非一成不变;我们与客户和合作伙伴在闭环反馈系统中不断迭代,持续改进性能、降低成本并提升部署灵活性。这份不断发展的蓝图简化了客户的基础设施部署,提高了敏捷性和效率。

您能从 Vertiv 的角度解释一下 NVIDIA GB300 NVL72 是什么以及它的意义吗?

MO: NVIDIA GB300 NVL72 是一个综合平台,涵盖计算、网络和存储,专为企业加速计算而优化。它是一个计算单元,类似于历史上的笔记本电脑,但专为机架和行级 AI 设计。Vertiv 为该平台提供电源、冷却和控制框架,使其高效运行。GB300 NVL72 是 AI 集群的黄金标准,在服务器、机架和系统级别进行了优化。我们在使该平台能够为 AI 工作负载提供最佳性能方面发挥着至关重要的作用。

除了液体冷却之外,Vertiv 还为 NVIDIA 的 AI 基础设施带来了哪些其他价值,尤其是对于 GB300 NVL72?

MO: 虽然液体冷却至关重要—为节省能源,过渡到 80% 液体冷却和 20% 空气冷却—我们的价值将进一步延伸。我们在整个动力系统领域处于领先地位,从电网到芯片,并提供电池储能系统和微电网等解决方案来管理电网互动。我们还管理从芯片到热能再利用的整个热链。

我们的编排软件集成了电源和散热系统,以实现最佳性能。此外,我们提供灵活的部署模式,从完全预制的模块化数据中心到预集成的模块,从而降低风险并加快 GB300 NVL72 等大型 AI 系统的部署。

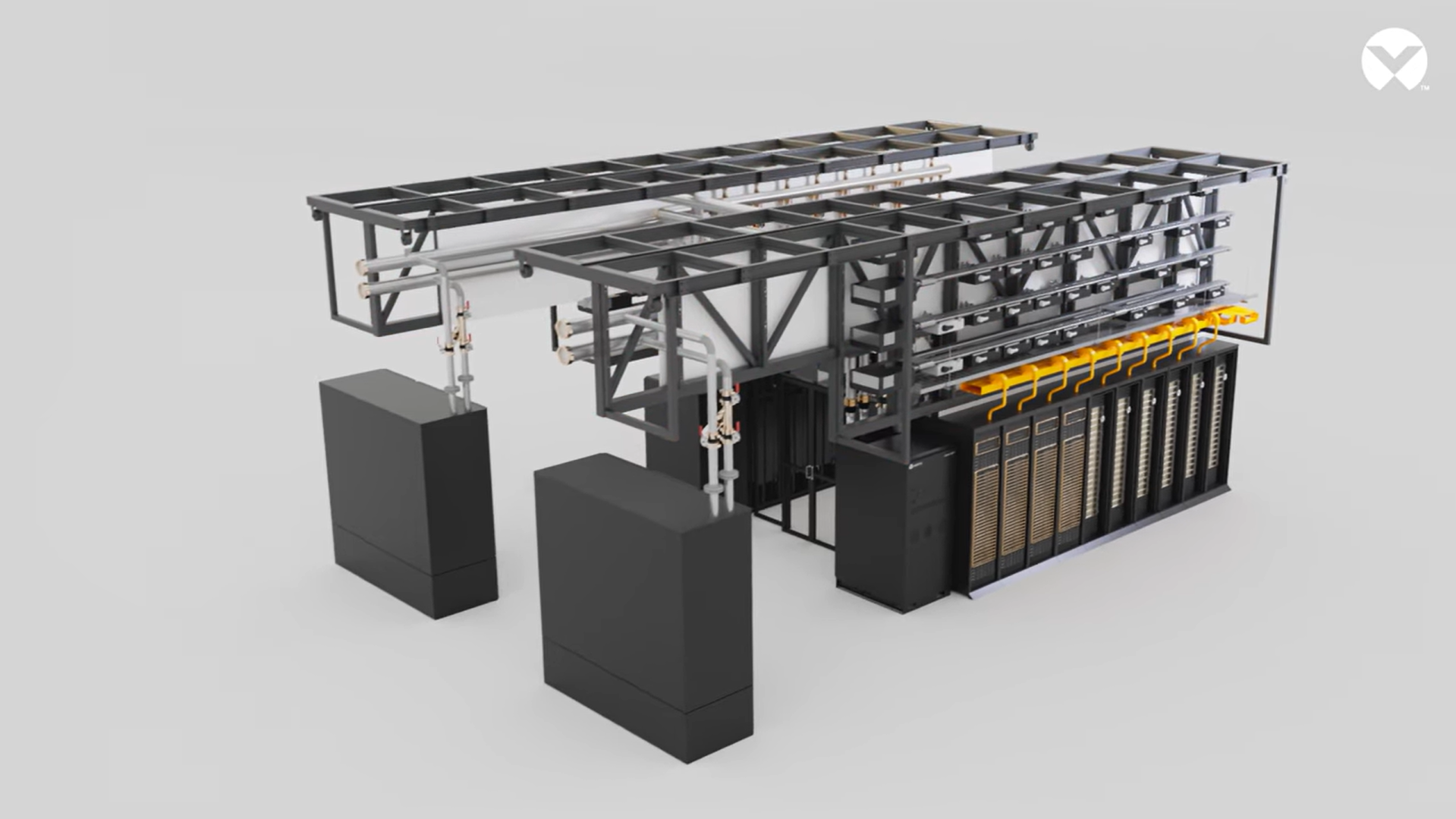

专为 NVIDIA GB200 平台设计并可扩展至 GB300 的高密度 AI 基础架构的 3D 渲染图。该基础架构支持 20 个 DGX 优化机架,负载高达 1.4 MW,并具备处理下一代工作负载的扩展空间,采用模块化设计,并搭载 Vertiv™ SmartRun 平台。—用于集成冷却、端到端电源和电缆管理的预制架空系统。

Vertiv 在此次合作中如何利用 NVIDIA 的 Omniverse 平台?

MO: 我们使用 NVIDIA Omniverse 创建基于物理、逼真的数字孪生模型,用于我们的参考架构,包括 GB300 NVL72 的参考架构。这使我们能够与建筑师、工程师和客户进行实时协作,从而在部署前快速进行设计迭代和验证。数字孪生模型可以模拟基础设施性能,虚拟测试各种变量和故障场景,从而节省时间并降低项目风险。此功能还扩展到运营领域,提供闭环优化和前馈控制,以持续提升系统性能,使其成为在整个生命周期内做出更智能的基础设施决策的动态工具。

您预计未来与 NVIDIA 将在哪些领域展开合作,尤其是在企业采用和新兴 AI 技术方面?

MO: 随着人工智能的发展,我们正在从训练转向推理,并通过放射学或银行等企业应用实现盈利。这种转变将创建一个分布式人工智能生态系统,小型模型将部署在本地、主机托管或边缘计算上,并由数据安全、主权、延迟和集成需求驱动。我们与 NVIDIA 的合作将专注于支持这种分布式格局,并利用 Omniverse 进行设计和优化。我们还将探索代理人工智能和物理人工智能等新兴领域,使我们的基础设施能够支持不同行业和地区的企业应用,从集中式人工智能工厂扩展到边缘部署。

人工智能时代的蓝图

Vertiv 与 NVIDIA 的合作标志着 AI 基础设施从定制化向可扩展、可重复的转变。GB300 NVL72 等参考设计树立了新的标准—将电源、冷却和编排集成到一个统一的系统中。随着人工智能从核心向边缘扩展,这种合作关系正在塑造下一代计算的部署方式。

探索 AI 基础设施的未来发展: Vertiv AI Hub:转型现代数据中心以支持 AI 和 HPC 需求