我有幸与 Vertiv 冷水机组业务发展经理 Sandro Gatto 共同主持 Vertiv 最新一期 “工程师前沿” 网络直播,探讨数据中心从风冷到液冷的转型。随着 IT 硬件密度的不断提升以及对可持续性的日益关注,我们预计液冷技术的应用将日益受到关注。

IT 电源趋势

人工智能 (AI)、自动化、高性能计算 (HPC) 和机器学习对处理能力的需求不断增长,导致每个芯片的热密度更高。这导致服务器产生更多必须散热的热量,并且在某些应用中,产生的热量达到了空气冷却不足以为这些高密度机架提供充分冷却的程度。

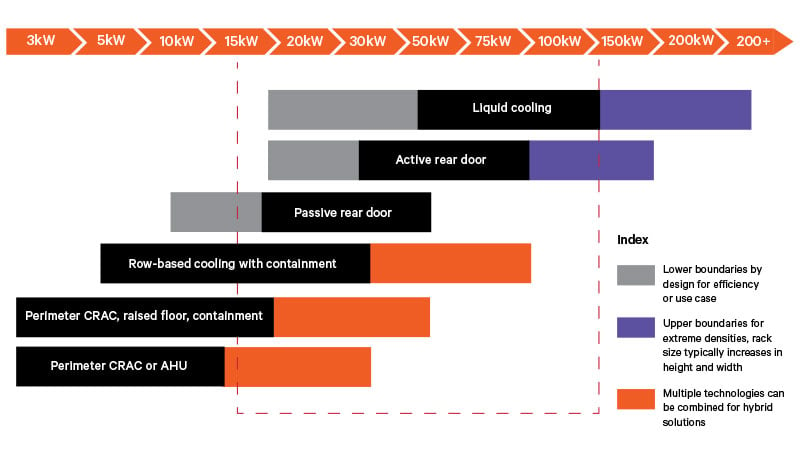

在特定机架密度范围内,根据设计要求,有多种散热管理技术可供选择。当机架密度接近甚至超过 30 千瓦 (kW) 时,风冷可能无法充分维持处理器的工作温度(机壳温度),因此液冷成为有效散热的唯一选择。

这是由于液体的热承载特性,其对于芯片的热量传递更为有效,可以通过直接到芯片(D2C)或浸入式冷却方法完成。

效率

液体冷却是冷却数据中心的更有效的方式,原因有二:

-

可以提高工作流体的供给温度以维持处理器的运行状态,而无需增加风扇功率,因为冷却作用直接作用于最热的组件(通常是处理器)。我们承认,在传统的风冷系统中,处理器与冷却板之间的传热效率远高于处理器与周围空气之间的传热效率,从而有利于提高数据中心的整体效率。

-

与传统空气冷却相比,机架的回水温度更高,可以比空气冷却数据中心更有效地回收热量。

随着应用对计算能力要求的不断提升,人们将转向创新的热管理技术,以更好地管理这些更高的功率密度。我们预计许多数据中心将引入混合热管理系统,包括风冷和液冷。

液体冷却技术

支持直接芯片液冷系统的过渡与我们熟悉的标准机架非常相似,不同之处在于,机架设计将包含一个液体歧管,用于将工作液体分配到支持直接芯片的IT设备(ITE)。机架内部的管道将与行级的液体分配歧管相匹配,以将液体输送到机架,所有这些都由冷却分配单元(CDU)控制。为此,需要对设施技术空间进行更改,这需要进行适当的规划。

浸入式冷却系统需要与数据中心布局不同的布局,标准机架布局被水平放置的冷却水箱取代,而非传统的垂直机架布局。在这种数据中心中,ITE 设备完全浸入导热介电液体或流体(不导电的流体)中。浸入式冷却是一项前景广阔的技术,但由于缺乏全面的标准,目前尚未完全成熟。数据中心运营团队通常不熟悉这项技术,需要在安装和运行之前进行知识转移,因此需要提升他们的技能。

两种技术的共同方法是利用位于 TCL(技术冷却回路)和 FCL(设施冷却回路)之间的带有液-液板式热交换器的 CDU,在 TCL 和 FCL 之间传递热量,TCL 在清洁度方面有严格的要求,过滤要求比 FCL 的要求高得多。

这两种技术都可以使用单相流体或相变流体(称为双相流体),由于当液体蒸发成气态时有利于热传递,因此效率更高。

指标

混合数据中心设计预计将会流行,因此衡量整个数据中心效率的指标变得至关重要。我们需要考虑超越传统PUE(电源使用效率)指标的指标,以便将液体冷却系统带来的风扇功率降低纳入考量。

Vertiv 与我们的合作伙伴共同开展了一项研究,展示了不同的指标,例如 TUE(总体使用效率),反映了整个数据中心设计的总功耗降低。

在我们的博客中阅读有关 TUE 指标的更多信息: 量化将液体冷却引入风冷数据中心时对 PUE 和能耗的影响。

此外,还可以了解有关 Vertiv™ Liebert® XDU 冷却液分配装置的更多信息,该装置适用于芯片和后门冷却应用,并且易于在任何数据中心部署且经济高效。

最后,别忘了聆听整个 工程师前沿顾问系列, 了解 Vertiv 专家对最新技术的见解。