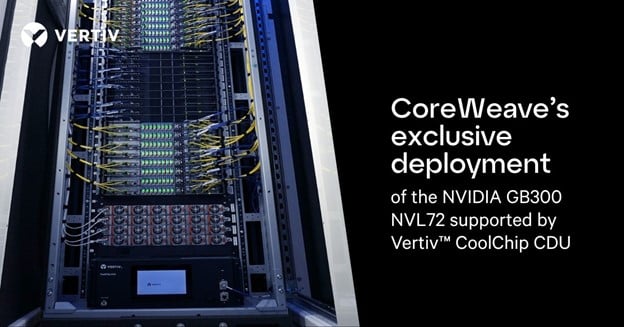

CoreWeave 及其合作伙伴已在全球首次实现 NVIDIA GB300 NVL72 系统的云部署,从而实现更快的训练、更低的延迟和更高效的实时 AI 基础设施。

一支备受赞誉的管弦乐队不仅仅是一群世界级音乐家的集合;它是一个独特的整体,其中的每个部分 (铜管乐器、弦乐、打击乐器) 都经过精确的时间和调音,以提供完美的表演。

同样的原则也适用于 AI 基础设施。关键任务 AI 性能提升不仅仅在于增加 GPU,更在于协调计算、供电、散热和网络,使它们能够作为一个系统、一个单元运行。

这正是 Vertiv、CoreWeave 及其合作伙伴针对 NVIDIA GB300 NVL72 系统所规划的。这并非一个概念,也不是一次性的定制产品。它是为大规模 AI 构建的统一基础架构。

人工智能基础设施的新标准

CoreWeave 是 GPU 和云计算领域的 AI 超大规模提供商,目前正在戴尔集成机架系统中首次部署 NVIDIA GB300 NVL72。(探索架构)

CoreWeave 一直处于 AI 云基础设施的前沿,此前已部署了 NVIDIA HGX H100 和 H200 平台。其 NVIDIA GB300 NVL72 的部署延续了这一趋势。

性能提升不言而喻:

- 与 Hopper 相比,推理工作负载的推理输出有所增加了50 倍×

- 提高用户响应能力10× 倍

- 每瓦吞吐量提高5× 倍

- 与 Blackwell 相比,FP4(4 位浮点)性能提高1.5× 倍

- 与Blackwell相比,每个机架的GPU内存高达21TB,内存增加1.5× 倍

- 与上一代系统相比,每个GPU的NVIDIA Quantum InfiniBand带宽增加了2× 倍

可随芯片扩展的基础设施

要运行如此规模的系统,冷却和电源的设计必须与计算一样精心。满负荷时,每个 NVIDIA GB300 NVL72 机架的功耗约为 140 千瓦,并且采用液冷。Vertiv 的贡献至关重要。

Vertiv™ CoolChip 冷却分配单元 (CDU) 专为这些条件而设计。该系统可提供:

- 121kW 液体对液体散热, 尺寸理想,并针对 NVIDIA GB300 NVL72 机柜进行了优化

- 与 ASHRAE W5 进水温度兼容

- 冗余泵和双热交换器, 用于容错

- 自动回路控制 ,确保稳定运行

Vertiv 的功能还包括简化部署和优化效率的服务,包括:

- CFD(计算流体动力学)建模 和热模拟,以优化气流并避免后期重新设计

- 空白空间和集成规划 ,使冷却、电源和回路控制与机架布局保持一致

- 实时监控和循环控制 ,以在动态 GPU 负载下稳定性能

- NVIDIA GB200 和 GB300 系统的参考设计和 SimReady 资产 ,可在构建之前进行数字验证

CoreWeave 部署的 NVIDIA GB300 NVL72 机架正面图,展示了由 Vertiv™ CoolChip CDU(冷却液分配单元)液冷系统支持的高性能 GPU 基础架构,该系统旨在应对极端热负荷。(图片由 Switch 提供)

快速执行人工智能—与维谛一起

交付下一代 AI 基础设施不仅仅关乎机架内部,还关乎从设计到部署的快速推进,以及合作伙伴在整个过程中的紧密配合。

CoreWeave 推出的 NVIDIA GB300 NVL72 展示了这一实践过程:通过协作努力将机架规模的 AI 平台上线,该平台专为约 140kW 负载、液冷和密集、始终在线的推理工作负载而构建。

正如 CoreWeave 使用体育而非音乐的类比所说:

开拓人工智能基础设施的未来是一项团队运动。我们与戴尔、Switch 和 Vertiv 携手合作,共同部署 NVIDIA GB300 NVL72,这对于我们的速度和敏捷性至关重要,并为我们以前所未有的速度将突破性技术转化为现实,为我们的客户提供了所需的关键支持。

Vertiv 通过预先验证的液体冷却系统和工程专业知识支持部署,为 CoreWeave 和戴尔提供光速发展所需的基础设施协调。

基础设施的发展方向

CoreWeave 和戴尔在 Vertiv 的支持下部署了 NVIDIA GB300 NVL72,标志着 AI 基础设施设计和交付方式的转变。鉴于 AI 的发展速度,更合适的类比或许是电子音乐而非古典音乐。但无论 AI 以何种形式呈现,与其说是一群独奏者,不如说是一个团结的管弦乐队或团体。真正的融合、合作与共同发展对于一场交响乐般的 AI 演出至关重要。

了解如何集成电源、冷却和计算以在 Vertiv AI 中心实现最佳 AI 性能。